Ideas, información y conocimientos compartidos por el equipo

de Investigación, Desarrollo e Innovación de BASE4 Security.

Referencias

⦁ CCN-CERT: Aproximación a la Inteligencia Artificial

y la ciberseguridad (octubre 2023)

IA aplicada a la Ciberseguridad

En este post haremos un breve recorrido por el informe de buenas prácticas “Aproximación a la Inteligencia Artificial y la Ciberseguridad” publicado por el CCN-CERT

La relación entre la IA y la ciberseguridad se ha consolidado con el paso de los últimos años. Inicialmente, los sistemas de ciberseguridad se basaban principalmente en firmas y reglas predefinidas para detectar las amenazas. Sin embargo, con el aumento y la evolución de las ciberamenazas, la necesidad de sistemas más avanzados y adaptativos se ha hecho evidente.

Importancia de la temática

La ciberseguridad hace varios años que tiene un alcance más allá de lo técnico y se ha convertido en una preocupación global que afecta a instituciones, empresas y personas. Con la digitalización y la interconexión de infraestructuras críticas, la protección de estos sistemas es esencial debido a las características de la transformación digital.

La inteligencia artificial (IA) desempeña un papel fundamental en este contexto, ya que puede manejar grandes volúmenes de datos, adaptarse a las amenazas en constante evolución, automatizar respuestas, identificar patrones complejos, incluso ayudar a abordar la escasez de profesionales en ciberseguridad.

Sin embargo, también plantea desafíos éticos y regulatorios que deben abordarse para garantizar su uso justo y responsable.

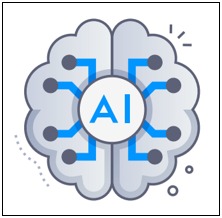

Inteligencia Artificial

La IA ha evolucionado de un concepto teórico a una herramienta práctica con aplicaciones en diversas áreas, incluyendo la ciberseguridad. En este contexto, la IA ofrece capacidades avanzadas que superan los métodos tradicionales de seguridad.

Para comprender cómo beneficia a la ciberseguridad, es crucial conocer las diversas técnicas de IA, como el aprendizaje automático, la lógica difusa, las redes neuronales y la IA generativa. Cada técnica tiene sus propias ventajas y aplicaciones en la defensa contra las amenazas cibernéticas en constante evolución. Este resumen proporciona una base sólida para comprender cómo la IA está transformando la protección de sistemas y datos en la ciberseguridad.

Machine Learning (Aprendizaje Automático)

Una rama de la inteligencia artificial que se enfoca en desarrollar algoritmos y modelos que permiten a las computadoras aprender y tomar decisiones basadas en datos sin necesidad de programación explícita. Los algoritmos de Machine Learning pueden detectar patrones, hacer predicciones y tomar decisiones a medida que se les proporciona más información.

Deep Learning (Aprendizaje Profundo)

Es una subcategoría del Machine Learning que se basa en redes neuronales artificiales con múltiples capas (llamadas redes neuronales profundas) para realizar tareas de aprendizaje automático de alto nivel. Se utiliza en aplicaciones como reconocimiento de imágenes, procesamiento de lenguaje natural y visión por computadora.

Algoritmos de Clasificación

Estas son técnicas de Machine Learning que se utilizan para asignar datos a categorías o clases predefinidas. Estos algoritmos analizan características o atributos de los datos y los utilizan para tomar decisiones de clasificación. Ejemplos comunes de algoritmos de clasificación incluyen regresión logística, árboles de decisión y máquinas de vectores de soporte (SVM).

IA Generativa

La IA Generativa se refiere a un conjunto de técnicas y modelos de inteligencia artificial que se utilizan para generar datos, contenido o información de manera autónoma. Esto puede incluir la creación de imágenes, texto, música o cualquier otro tipo de contenido creativo. Un ejemplo destacado de IA Generativa es la red neuronal generativa adversativa (GAN), que se utiliza para crear imágenes realistas y otros tipos de datos sintéticos.

Cada una de estas ramas pueden aplicarse al campo de la ciberseguridad a través de, por ejemplo:

• La detección de amenazas (identificando patrones en grandes volúmenes de datos)

• El análisis de código malicioso (o la creación de muestras)

• La detección de fraudes (ej. Phishing)

• Emulación de Adversarios

• Generación de contenido pseudo real o malicioso (útil para entrenar sistemas de detección)

IA Generativa y Ciberseguridad

La inteligencia artificial (IA) generativa se ha vuelto valiosa en diversos campos, incluyendo la ciberseguridad, donde ofrece tanto beneficios como posibles amenazas.

Entre algún beneficio para este campo encontramos la posibilidad de generar datos sintéticos para entrenar sistemas de detección de intrusos sin comprometer la privacidad, la simulación de ataques para probar la robustez de sistemas, la creación de escenarios realistas de pruebas de penetración y el refuerzo del aprendizaje para mejorar la detección y respuesta a amenazas en tiempo real.

Sin embargo, también plantea desafíos y amenazas potenciales que deben abordarse con precaución:

• Vulnerabilidades durante y después del entrenamiento del modelo: Los modelos de IA generativa pueden exponer datos de entrenamiento a riesgos de seguridad, ya que no siempre se sabe qué datos se utilizan y cómo se almacenan.

• Violación de la privacidad de los datos personales: La falta de regulación en cuanto a los datos introducidos en modelos generativos puede llevar a la utilización de datos sensibles sin cumplir normativas ni obtener permisos, lo que podría resultar en la exposición de información personal.

• Exposición de la propiedad intelectual: Organizaciones han expuesto involuntariamente datos de propiedad a modelos generativos, especialmente cuando se cargan elementos sujetos a propiedad intelectual, claves API y datos confidenciales.

• Jailbreaks y soluciones de ciberseguridad: Los usuarios pueden utilizar jailbreaks para enseñar a modelos generativos a trabajar en contra de sus reglas, lo que puede llevar a esquemas sofisticados de phishing y malware.

• Creación de malware y ataques: Actores maliciosos pueden utilizar técnicas generativas para generar malware que evite sistemas de detección tradicionales.

• Phishing y engaño: Las herramientas de IA generativa pueden ser usadas para crear comunicaciones falsas que imitan a las legítimas, aumentando la efectividad de los ataques de phishing.

• Manipulación y falsificación de datos: Técnicas generativas pueden ser utilizadas para crear registros de logs falsos o manipular datos, lo que dificulta la detección de ataques.

• Deepfakes: La capacidad de crear deepfakes puede ser utilizada en ataques dirigidos para engañar a empleados o ejecutivos.

Consejos y buenas prácticas

Sabiendo entonces que el uso de IA generativa presenta, como hemos visto, significativos desafíos, no parece que esté de más compartir algunos consejos y buenas Prácticas en materia de Ciberseguridad para el uso de la IA generativa

• Leer atentamente las políticas de seguridad de los proveedores de IA generativa: Es esencial comprender las políticas de seguridad de los proveedores de IA generativa, especialmente en lo que respecta a la transparencia en el entrenamiento de modelos, la eliminación de datos, la trazabilidad y las opciones de inclusión y exclusión voluntarias.

• No introducir datos sensibles cuando se utilicen modelos generativos: Para proteger datos sensibles, evite utilizarlos en modelos generativos, especialmente si no está familiarizado con su funcionamiento. En lugar de confiar en los protocolos de seguridad de los proveedores, considere crear copias sintéticas de los datos o evitar el uso de estas herramientas con datos sensibles.

• (Siempre que sea posible) Mantener actualizados los modelos generativos de IA: Los modelos generativos reciben actualizaciones periódicas que pueden incluir correcciones de errores y mejoras de seguridad. Manténgalos actualizados para garantizar su eficacia continua.

• Formar a los empleados sobre el uso adecuado: Los empleados deben comprender qué datos pueden usar como entradas, cómo beneficiarse de las herramientas de IA generativa y cuáles son las expectativas de cumplimiento normativo. Además, deben cumplir con las regulaciones generales de la organización relacionadas con el uso de medios electrónicos.

• Utilizar herramientas y políticas claras de gobierno y seguridad de datos: Considere invertir en herramientas de prevención de pérdida de datos, inteligencia de amenazas, plataforma de protección de aplicaciones nativas de la nube y/o detección y respuesta ampliadas (XDR) para proteger su entorno.

Dependencia de soluciones automatizadas

Resulta sumamente de valor reflexionar sobre la dependencia excesiva de soluciones automatizadas en ciberseguridad, sabiendo que esto puede tener implicaciones significativas y riesgos asociados

Carencia de Interpretabilidad: La IA, especialmente el aprendizaje profundo, a menudo es difícil de comprender, lo que plantea preocupaciones en la ciberseguridad, donde la trazabilidad y comprensión son esenciales.

Falsa sensación de seguridad: La implementación de soluciones de IA NO GARANTIZA una protección completa, y confiar exclusivamente en ellas puede llevar a la falta de preparación para responder a amenazas.

Evolución de amenazas: Los atacantes cambian constantemente sus métodos, y si las soluciones de IA no se actualizan, pueden volverse obsoletas rápidamente.

Ataques contra la IA: Los atacantes desarrollan técnicas específicas para eludir sistemas basados en IA, lo que representa un riesgo si se depende en exceso de estas soluciones.

Fallos en la automatización: Los sistemas de IA son tan buenos como los datos con los que se entrenaron, y datos no representativos pueden llevar a predicciones incorrectas o a no detectar amenazas.

Desplazamiento del juicio humano: La experiencia humana sigue siendo esencial en ciberseguridad, ya que los equipos humanos comprenden intuitivamente los sistemas y redes.

Coste de mantenimiento y actualización: Mantener y actualizar sistemas de IA puede requerir inversiones significativas en tiempo y recursos.

En forma de conclusión, se puede ver que las implementaciones de IA deben ser vista como una herramienta complementaria en la ciberseguridad, no como un reemplazo de métodos y técnicas tradicionales.

La combinación de la experiencia humana con la IA y el cumplimiento de las leyes es crucial para defenderse contra las ciberamenazas en constante evolución.