Ideias, informações e conhecimentos compartilhados pela equipe

de Investigação, Desenvolvimento e Inovação da BASE4 Security.

Referências

⦁ CCN-CERT: Abordagem da inteligência artificial

e da segurança cibernética (outubro de 2023)

IA aplicada à segurança cibernética

Nesta postagem, daremos uma breve olhada no relatório de práticas recomendadas "Approaching Artificial Intelligence and Cybersecurity" publicado pela CCN-CERT.

A relação entre IA e segurança cibernética foi consolidada nos últimos anos. Inicialmente, os sistemas de segurança cibernética dependiam principalmente de assinaturas e regras predefinidas para detectar ameaças. No entanto, com o aumento e a evolução das ameaças cibernéticas, a necessidade de sistemas mais avançados e adaptáveis tornou-se evidente.

Importância do assunto

Há vários anos, a segurança cibernética tem um escopo que vai além do técnico e se tornou uma preocupação global que afeta instituições, empresas e indivíduos. Com a digitalização e a interconexão de infraestruturas críticas, a proteção desses sistemas é essencial devido às características da transformação digital.

A inteligência artificial (IA) desempenha um papel fundamental nesse contexto, pois pode lidar com grandes volumes de dados, adaptar-se às ameaças em evolução, automatizar respostas, identificar padrões complexos e até mesmo ajudar a resolver a escassez de profissionais de segurança cibernética.

No entanto, ela também apresenta desafios éticos e regulatórios que precisam ser abordados para garantir seu uso justo e responsável.

Inteligência Artificial

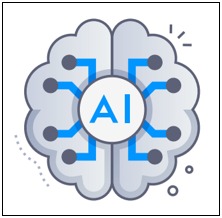

A IA evoluiu de um conceito teórico para uma ferramenta prática com aplicações em várias áreas, inclusive na segurança cibernética. Nesse contexto, a IA oferece recursos avançados que vão além dos métodos de segurança tradicionais.

Para intender como ela beneficia a segurança cibernética, é fundamental compreender as várias técnicas de IA, como aprendizado de máquina, lógica difusa, redes neurais e IA generativa. Cada técnica tem suas próprias vantagens e aplicações na defesa contra ameaças cibernéticas em constante evolução. Este resumo fornece uma base sólida para intender como a IA está transformando a proteção de sistemas e dados na segurança cibernética.

Aprendizado de máquina

Um ramo da inteligência artificial que se concentra no desenvolvimento de algoritmos e modelos que permitem que os computadores aprendam e tomem decisões com base em dados sem a necessidade de programação explícita. Os algoritmos de aprendizado de máquina podem detectar padrões, fazer previsões e tomar decisões à medida que recebem mais informações.

Aprendizagem profunda

Uma subcategoria do aprendizado de máquina que se baseia em redes neurais artificiais de várias camadas (chamadas de redes neurais profundas) para executar tarefas de aprendizado de máquina de alto nível. É usada em aplicativos como reconhecimento de imagens, processamento de linguagem natural e visão computacional.

Algoritmos de classificação

Essas são técnicas de aprendizado de máquina usadas para atribuir dados a categorias ou classes predefinidas. Esses algoritmos analisam os recursos ou atributos dos dados e os utilizam para tomar decisões de classificação. Exemplos comuns de algoritmos de classificação incluem regressão logística, árvores de decisão e máquinas de vetor de suporte (SVM).

IA generativa

A IA generativa refere-se a um conjunto de técnicas e modelos de inteligência artificial que são usados para gerar dados, conteúdo ou informações de forma autônoma. Isso pode incluir a criação de imagens, textos, músicas ou qualquer outro tipo de conteúdo criativo. Um exemplo importante de IA generativa é a rede neural adversarial generativa (GAN), que é usada para criar imagens realistas e outros tipos de dados sintéticos.

Cada una de estas ramas pueden aplicarse al campo de la ciberseguridad a través de, por ejemplo:

• Detecção de ameaças (identificação de padrões em grandes volumes de dados)

• Análise de código malicioso (ou criação de amostra)

• Detecção de fraudes (por exemplo, phishing)

• Emulação de adversários

• Geração de conteúdo pseudo-real ou malicioso (útil para treinar sistemas de detecção)

IA generativa e segurança cibernética

A inteligência artificial (IA) generativa tornou-se valiosa em vários campos, inclusive na segurança cibernética, onde oferece benefícios e possíveis ameaças.

Entre alguns dos benefícios para o campo estão a capacidade de gerar dados sintéticos para treinar sistemas de detecção de intrusão sem comprometer a privacidade, simulando ataques para testar a robustez dos sistemas, criando cenários realistas de testes de penetração e reforçando o aprendizado para melhorar a detecção e a resposta a ameaças em tempo real.

No entanto, ela também apresenta desafios e possíveis ameaças que precisam ser abordadas com cautela:

• Vulnerabilidades durante e após o treinamento do modelo: os modelos de IA generativa podem expor os dados de treinamento a riscos de segurança, pois nem sempre se sabe quais dados são usados e como são armazenados.

• Violação da privacidade de dados pessoais: a falta de regulamentação dos dados inseridos em modelos generativos pode levar ao uso de dados confidenciais sem cumprir as regulamentações ou obter permissões, o que pode resultar na exposição de informações pessoais.

• Exposição à propriedade intelectual: as organizações expuseram involuntariamente dados proprietários a modelos generativos, especialmente ao fazer upload de elementos proprietários, chaves de API e dados confidenciais.

• Jailbreaks e soluções de segurança cibernética: os usuários podem usar jailbreaks para ensinar modelos generativos a trabalhar contra suas regras, o que pode levar a esquemas sofisticados de phishing e malware.

• Criação e ataques de malware: os agentes mal-intencionados podem usar técnicas generativas para gerar malware que foge dos sistemas de detecção tradicionais.

• Phishing e engano: ferramentas de IA generativas podem ser usadas para criar comunicações falsas que imitam as legítimas, aumentando a eficácia dos ataques de phishing.

• anipulação e falsificação de dados: as técnicas generativas podem ser usadas para criar registros de log falsos ou manipular dados, dificultando a detecção de ataques.

• Deepfakes: a capacidade de criar deepfakes pode ser usada em ataques direcionados para enganar funcionários ou executivos.

Dicas e práticas recomendadas

Sabendo, então, que o uso da IA generativa apresenta, como vimos, desafios significativos, não parece fora de lugar compartilhar algumas dicas de segurança cibernética e práticas recomendadas para o uso da IA generativa.

• Leia atentamente as políticas de segurança dos provedores de IA generativa: é essencial intender as políticas de segurança dos provedores de IA generativa, especialmente no que diz respeito à transparência do treinamento do modelo, à exclusão de dados, à rastreabilidade e às opções de inclusão e exclusão.

• Não insira dados confidenciais ao usar modelos generativos: para proteger dados confidenciais, evite usá-los em modelos generativos, especialmente se você não estiver familiarizado com o funcionamento deles. Em vez de confiar nos protocolos de segurança dos fornecedores, considere criar cópias sintéticas dos dados ou evite usar essas ferramentas com dados confidenciais.

• (Sempre que possível) Mantenha os modelos generativos de IA atualizados: os modelos generativos recebem atualizações periódicas que podem incluir correções de bugs e aprimoramentos de segurança. Mantenha-os atualizados para garantir sua eficácia contínua.

• Treinar os funcionários sobre o uso adequado: os funcionários devem entender quais dados podem usar como entradas, como se beneficiar das ferramentas de IA generativas e quais são as expectativas de conformidade. Além disso, eles devem cumprir as normas organizacionais gerais relacionadas ao uso de mídia eletrônica.

• Use ferramentas e políticas claras de segurança e governança de dados: Considere investir em ferramentas de prevenção de perda de dados, inteligência contra ameaças, plataforma de proteção de aplicativos nativos da nuvem e/ou detecção e resposta estendidas (XDR) para proteger seu ambiente.

Confiança em soluções automatizadas

É extremamente valioso refletir sobre a dependência excessiva de soluções automatizadas na segurança cibernética, sabendo que isso pode ter implicações significativas e riscos associados.

Falta de interpretabilidade: a IA, especialmente a aprendizagem profunda, costuma ser difícil de intender, o que gera preocupações em relação à segurança cibernética, em que a rastreabilidade e a compreensão são essenciais.

Falsa sensação de segurança: a implementação de soluções de IA NÃO GARANTE proteção completa, e confiar somente nelas pode levar a uma falta de preparo para responder a ameaças.

Evolução das ameaças: os atacantes estão constantemente mudando seus métodos e, se as soluções de IA não forem atualizadas, elas podem se tornar obsoletas rapidamente.

Ataques contra la IA: Los atacantes desarrollan técnicas específicas para eludir sistemas basados en IA, lo que representa un riesgo si se depende en exceso de estas soluciones.

Falhas na automação: Os sistemas de IA são tão bons quanto os dados com os quais são treinados, e dados não representativos podem levar a previsões incorretas ou à falha na detecção de ameaças.

Deslocamento do julgamento humano: o conhecimento humano continua sendo essencial na segurança cibernética, pois as equipes humanas entendem intuitivamente os sistemas e as redes.

Custo de manutenção e atualização: a manutenção e a atualização dos sistemas de IA podem exigir investimentos significativos em tempo e recursos.

Em conclusão, pode-se observar que as implementações de IA devem ser vistas como uma ferramenta complementar na segurança cibernética, e não como uma substituição dos métodos e técnicas tradicionais.

A combinação do conhecimento humano com a IA e a aplicação da lei é crucial para a defesa contra ameaças cibernéticas em constante evolução.